Avis RunPod 2025 : Votre Guide Complet

RunPod

4.5 / 5RunPod est une plateforme cloud pour développer, entraîner et déployer des modèles IA avec des GPU à la demande, simplement et efficacement.

Catégorie :

Sous-Catégories :

- Génération de code

- No-code

- Gestion de projet

- Recherche de données

Informations Générales

RunPod en 3 points

C’est quoi ?

RunPod est une plateforme cloud spécialisée dans l’IA développée pour faciliter le développement, l’entraînement et le déploiement de modèles IA en utilisant des GPU à la demande. Elle révolutionne la gestion des charges de travail AI grâce à son infrastructure scalable.

Pourquoi ?

Grâce à RunPod, les développeurs peuvent optimiser leurs processus en lançant des GPU en quelques secondes. Idéal pour entraîner des modèles AI rapidement et réduire les coûts, cette plateforme est indispensable pour une performance AI de pointe.

Pour qui ?

RunPod est parfait pour les développeurs AI, les chercheurs en IA, et les entreprises travaillant sur des projets d’envergure. Les startups et les grandes entreprises peuvent bénéficier de ses GPU flexibles et scalables, répondant à divers besoins.

Avantages et inconvénients

RunPod offre de nombreux avantages comme la scalabilité et la flexibilité pour les applications AI, mais présente aussi quelques inconvénients, notamment la complexité initiale pour les nouveaux utilisateurs.

Avantages de RunPod

- Scalabilité : Possibilité d’adapter dynamiquement les charges de travail en fonction des besoins en temps réel.

- Coût-efficacité : Options de paiement à l’utilisation, rendant le calcul GPU abordable.

- Temps de démarrage rapide : Pods GPU lancés en quelques secondes, minimisant les délais d’attente.

- Flexibilité : Support de plusieurs frameworks ML comme PyTorch et TensorFlow.

- Sécurité : Certification SOC 2, ISO 27001 et HIPAA en cours, assurant une infrastructure sécurisée.

Inconvénients de RunPod

- Langue : Disponible principalement en anglais, limitant l’accessibilité pour les non-anglophones.

- Complexité initiale : Prise en main complexe pour les novices en cloud computing et IA.

- Dépendance au cloud : Nécessite une connexion internet stable et rapide pour une utilisation optimale.

Langues Disponibles

RunPod favorise l’inclusivité avec son offre multilingue, bien que limitée. Pour l’instant, seules quelques langues sont disponibles, ce qui peut restreindre l’accessibilité pour un public international.

Liste des langues disponibles

- Anglais

- Langues supplémentaires non précisées

Domaines principaux

RunPod influence positivement divers secteurs tels que la recherche AI, l’analyse de données, et le développement de modèles AI. Elle génère des changements significatifs grâce à ses fonctionnalités puissantes et scalables. D’autres domaines bénéficient également de RunPod.

Recherche AI

Utilisation

RunPod permet aux chercheurs de lancer des expérimentations sur des algorithmes AI en utilisant des GPU performants. Par exemple, ils peuvent tester de nouveaux modèles ML avec une infrastructure scalable sans se soucier des limitations matérielles.

Résultats

Les chercheurs bénéficient d’une réduction du temps nécessaire pour les expérimentations et d’une augmentation de la précision des modèles. Les résultats sont obtenus plus rapidement et permettent une avancée plus efficace dans leurs recherches AI.

Analyse de données

Utilisation

Dans le secteur de l’analyse de données, RunPod permet de traiter de grandes quantités de données rapidement. Par exemple, les analystes peuvent exécuter des algorithmes complexes pour découvrir des tendances cachées en peu de temps.

Résultats

L’analyse des données devient plus efficace et les insights sont obtenus plus rapidement, aidant les entreprises à prendre des décisions basées sur des données en temps réel et à améliorer leur stratégie globale.

Développement de modèles AI

Utilisation

RunPod facilite le développement de modèles AI en fournissant des environnements GPU préconfigurés avec des frameworks populaires comme PyTorch et TensorFlow. Les développeurs peuvent rapidement coder, entraîner et évaluer leurs modèles.

Résultats

Les développeurs bénéficient d’une augmentation de productivité, une réduction des délais de mise en œuvre et une optimisation des performances des modèles, ce qui accelère le cycle de déploiement AI.

Entraînement de modèles ML

Utilisation

Pour l’entraînement de modèles ML, RunPod offre une puissance de calcul adaptée. Par exemple, des équipes peuvent entraîner des réseaux neuronaux assez rapidement grâce à des GPU haute performance.

Résultats

Les modèles ML atteignent une haute performance plus rapidement, permettant aux équipes de produire des modèles plus précis et d’améliorer continuellement leurs solutions AI tout en réduisant les coûts.

Déploiement d’applications AI

Utilisation

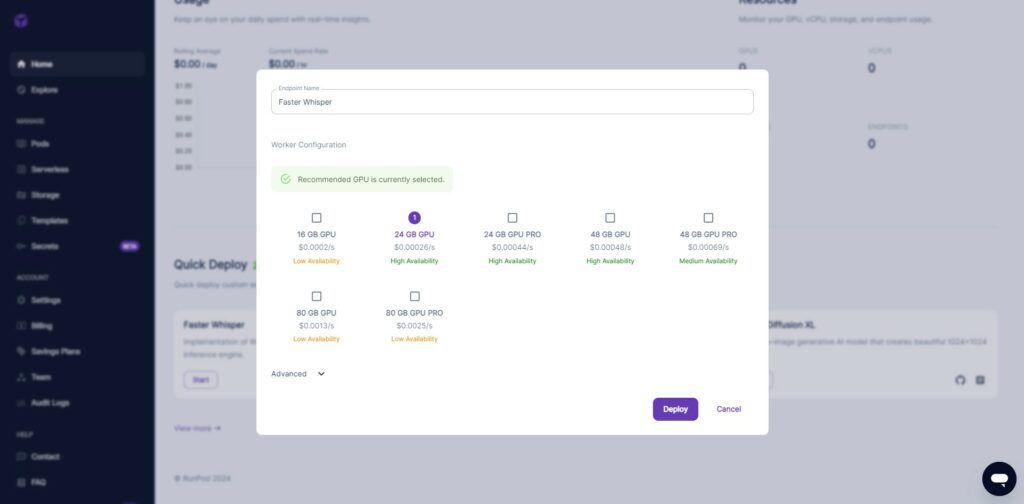

RunPod est utilisée pour le déploiement d’applications AI en production. Par exemple, des développeurs peuvent déployer des modèles AI directement via un environnement serverless, ce qui facilite la gestion et le scaling.

Résultats

Les applications AI sont déployées plus rapidement et efficacement. Le scalabilité automatique permet de gérer facilement la montée en charge, améliorant ainsi la fiabilité et la performance des applications en production.

Fonctionnalités principales

Voici les descriptions des fonctionnalités techniques de RunPod et leur impact sur l’expérience utilisateur.

Fonctionnalités techniques de RunPod

RunPod améliore l’expérience utilisateur avec traitement automatisé, analyse de données, et génération d’image grâce à des GPU puissants et une infrastructure scalable.

Traitement automatisé

Utilise des algorithmes avancés pour lancer des pods GPU automatiquement selon les besoins, optimisant ainsi les ressources et réduisant les coûts tout en augmentant l’efficacité.

Exemple d’utilisation

Un développeur utilise RunPod pour automatiser le lancement de pods GPU lors de l’entraînement de modèles AI, réduisant ainsi le temps de configuration et augmentant la productivité.

Analyse de données

Exécute des algorithmes complexes sur de grandes quantités de données, permettant des analyses rapides et précises. Idéal pour le machine learning et les gros volumes de données.

Exemple d’utilisation

Un analyste utilise RunPod pour traiter des ensembles de données massifs, découvrant des insights précieux en quelques heures plutôt qu’en plusieurs jours.

Génération d’image

Utilise des outils puissants pour la création et manipulation d’images. Idéal pour les tâches de vision par ordinateur, augmentant la qualité et la vitesse des processus créatifs.

Exemple d’utilisation

Un designer utilise RunPod pour générer et améliorer des images haute résolution, optimisant ainsi le rendu visuel des projets en un temps record.

Conseils d'utilisation

RunPod est une plateforme puissante permettant de maximiser les performances en intelligence artificielle grâce à ses fonctionnalités cloud. Suivre ces conseils et éviter ces erreurs est crucial pour une utilisation optimale.

Conseils pour une utilisation efficace

Maximisez l’utilisation de RunPod en suivant ces conseils simples pour améliorer votre productivité et tirer le meilleur parti de ses fonctionnalités avancées.

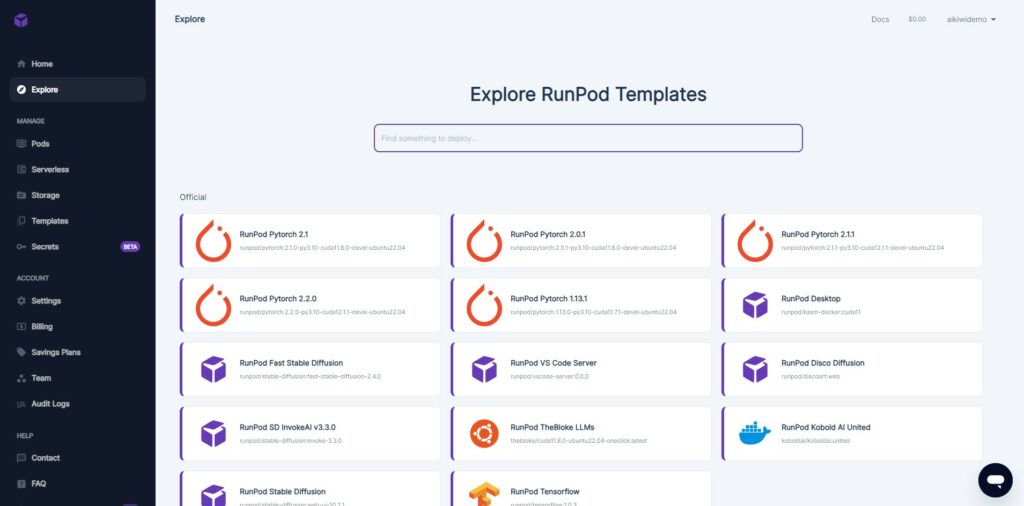

Conseil n°1 : Utiliser les templates préconfigurés

Les templates préconfigurés permettent un démarrage rapide. Ils offrent des environnements préinstallés, réduisant le temps de setup et les risques d’erreurs de configuration.

Conseil n°2 : Surveiller les performances en temps réel

Utilisez les outils de monitoring en temps réel pour suivre l’utilisation des ressources et ajuster les paramètres afin d’optimiser la performance de vos pods GPU.

Conseil n°3 : Automatiser les tâches répétitives

Utilisez le CLI RunPod pour automatiser les déploiements et exécutions de vos modèles. Cela permet de réduire le temps passé sur des tâches répétitives et d’augmenter l’efficacité.

Erreurs communes à éviter

Éviter ces erreurs est crucial pour garantir une utilisation efficace de RunPod et éviter les inefficacités qui peuvent survenir.

Erreur n°1 : Ignorer les mises à jour des templates

Ne pas mettre à jour régulièrement vos templates peut entraîner des problèmes de compatibilité. Assurez-vous d’utiliser les versions les plus récentes pour des performances optimales.

Erreur n°2 : Sous-estimer les ressources nécessaires

Allouer trop peu de ressources peut ralentir vos projets. Prenez le temps de comprendre vos besoins en calcul pour garantir une exécution fluide.

Erreur n°3 : Négliger la sécurisation des données

La sécurisation des données est essentielle. Utilisez les options de stockage sécurisé et suivez les meilleures pratiques de sécurité pour protéger vos informations sensibles.

Appareils, applications et systèmes compatibles

Internet

- Site officiel de RunPod

- API de RunPod

Application

- Windows

- macOS

- Linux

Plus

- Accès via Discord

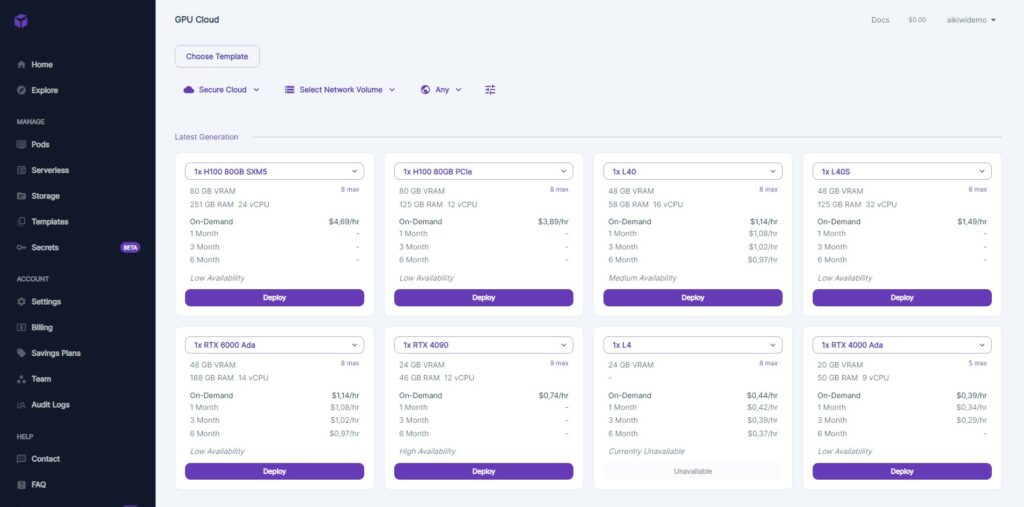

Tableau des prix

L’objectif de cette section est de comparer de manière concise les options tarifaires de RunPod pour aider les utilisateurs à choisir le plan qui leur convient le mieux.

| Nom du Plan | Public Cible | Fonctionnalités Clés | Prix et Modalités de Paiement | Limitations Importantes |

|---|---|---|---|---|

| A40 | Développeurs individuels et petites équipes | 48GB VRAM, 50GB RAM, 9 vCPUs | $0.39/heure (Secure Cloud), $0.47/heure (Community Cloud) | … |

| L40 | Développeurs et équipes de taille moyenne | 48GB VRAM, 250GB RAM, 16 vCPUs | $0.99/heure (Secure Cloud) | … |

| L40S | Développeurs et équipes de taille moyenne | 48GB VRAM, 62GB RAM, 12 vCPUs | $1.03/heure (Secure Cloud), $0.79/heure (Community Cloud) | … |

| RTX A6000 | Développeurs et équipes de taille moyenne | 48GB VRAM, 50GB RAM, 8 vCPUs | $0.76/heure (Secure Cloud), $0.49/heure (Community Cloud) | … |

| RTX A5000 | Développeurs individuels et petites équipes | 24GB VRAM, 24GB RAM, 4 vCPUs | $0.43/heure (Secure Cloud), $0.22/heure (Community Cloud) | … |

| RTX 4090 | Développeurs individuels et petites équipes | 24GB VRAM, 24GB RAM, 6 vCPUs | $0.69/heure (Secure Cloud), $0.44/heure (Community Cloud) | … |

| RTX 3090 | Développeurs individuels et petites équipes | 24GB VRAM, 24GB RAM, 4 vCPUs | $0.43/heure (Secure Cloud), $0.22/heure (Community Cloud) | … |

| RTX A4000 Ada | Développeurs individuels et petites équipes | 20GB VRAM, 31GB RAM, 4 vCPUs | $0.38/heure (Secure Cloud), $0.20/heure (Community Cloud) | … |

| A100 PCIe | Grandes équipes et entreprises | 80GB VRAM, 83GB RAM, 8 vCPUs | $1.64/heure (Secure Cloud), $1.19/heure (Community Cloud) | … |

| A100 SXM | Grandes équipes et entreprises | 80GB VRAM, 125GB RAM, 16 vCPUs | $1.89/heure (Secure Cloud) | … |

| H100 PCIe | Grandes équipes et entreprises | 80GB VRAM, 176GB RAM, 16 vCPUs | $2.89/heure (Secure Cloud), $2.69/heure (Community Cloud) | … |

| MI300X | Grandes équipes et entreprises | 192GB VRAM, 283GB RAM, 24 vCPUs | $3.99/heure (Secure Cloud) | … |

Avis et notes par Aikiwi

Note Globale de RunPod

RunPod se distingue par sa scalabilité, sa flexibilité et son efficacité grâce aux GPU à la demande. Cependant, l’accès limité à l’anglais et la complexité initiale peuvent être des obstacles pour certains utilisateurs.

Investir dans RunPod est judicieux pour les développeurs, chercheurs, et entreprises cherchant une solution performante et flexible pour leurs projets AI. Sa valeur et ses performances justifient largement son coût.

Essayez RunPod pour analyser vos besoins en IA et découvrir comment ses fonctionnalités avancées peuvent améliorer votre productivité et efficacité dans des situations diverses, comme l’entraînement de modèles ML et le déploiement AI.

Avis détaillé sur RunPod

Design et Ergonomie

Le design épuré et la conception intuitive de l’interface améliorent grandement l’expérience utilisateur, facilitant ainsi la navigation et l’utilisation des fonctionnalités de RunPod.

Facilité d’Utilisation

RunPod offre une interface simple et des templates préconfigurés qui permettent un démarrage rapide et une utilisation facile, même pour les débutants en cloud computing.

Fonctionnalités et Outils

RunPod propose une vaste gamme de fonctions avancées comme la scalabilité et les GPU à la demande, répondant efficacement aux besoins des développeurs AI.

Performance et Fiabilité

Les performances élevées et la fiabilité des GPU de RunPod garantissent des temps de traitement rapides et des résultats précis, assurant une utilisation sans interruptions.

Innovation et Singularité

L’approche innovante de RunPod, notamment avec le Flashboot et le serverless computing, la distingue largement des autres plateformes, offrant ainsi une flexibilité exceptionnelle.

Support et Ressources Disponibles

RunPod fournit un support complet via Discord et email, avec une documentation détaillée et des ressources pédagogiques suffisantes pour guider les utilisateurs.

Rapport Qualité-Prix

Les offres tarifaires compétitives et la qualité des fonctionnalités font de RunPod une option rentable, surtout pour les développeurs et entreprises à la recherche de solutions flexibles.

Fonctionnement & Fonctionnalités

Comment utiliser RunPod?

Prise en main initiale

Créez un compte sur le site RunPod en fournissant vos informations personnelles. Configurez ensuite votre environnement de développement en choisissant parmi les templates disponibles. Lancez des pods GPU en quelques clics pour démarrer vos projets AI rapidement et sans complications.

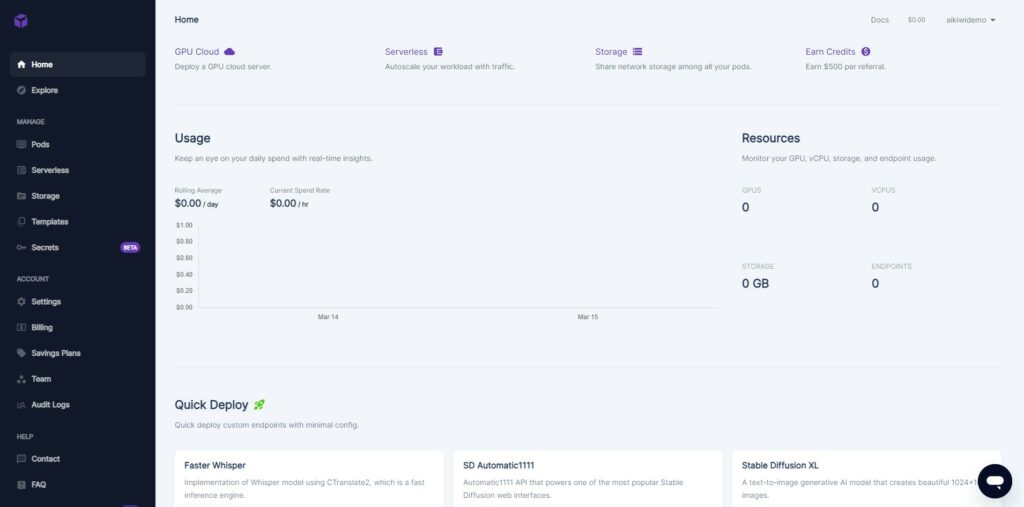

Navigation dans l’interface

L’interface de RunPod est intuitive, dotée d’un tableau de bord centralisé. Utilisez les sections de lancement, gestion des projets et surveillance des performances pour naviguer facilement. Accédez rapidement aux pods GPU, suivez vos tâches et ajustez les ressources selon vos besoins.

Utilisation et gestion de projets

Créez un projet en sélectionnant un template préconfiguré ou en important votre propre conteneur. Utilisez les outils de gestion des ressources pour suivre l’utilisation et ajuster les paramètres. Déployez et surveillez vos modèles ML en temps réel, optimisant ainsi la productivité et l’efficacité.